TL;DR

SeeDance 2.0 von ByteDance verschiebt Video-KI von zufälliger Generierung hin zu kontrollierter Produktion. Multimodale Inputs, Bewegungsübertragung und native Audiointegration ermöglichen planbare Workflows. Der technologische Fortschritt ist erheblich, bringt aber rechtliche und ethische Herausforderungen mit sich. Für Marketing und Agenturen liegt der Mehrwert nicht im Tool selbst, sondern in der strategischen Einbettung.

1. Warum SeeDance 2.0 gerade jetzt so viel Aufmerksamkeit bekommt

Innerhalb weniger Tage ist SeeDance 2.0 von einem internen Forschungsthema zu einem global diskutierten KI-Phänomen geworden. Demo-Clips mit 1080p-Auflösung, komplexen Kamerafahrten und überraschend kohärenten Actionszenen verbreiteten sich rasant auf Plattformen wie X, Reddit und chinesischen Netzwerken. Viele Beobachter hatten ein Déjà-vu: Als OpenAI erstmals Sora zeigte, war die Reaktion ähnlich. Doch diesmal wirkt der Schritt größer – weniger experimentell, stärker produktionsnah.

Warum gerade jetzt? Die Entwicklung generativer Video-KI befindet sich an einem Wendepunkt. Die erste Welle bestand aus Text-zu-Video-Modellen, die beeindruckende, aber oft instabile Kurzclips erzeugten. Verzerrte Hände, flackernde Objekte oder physikalisch unlogische Bewegungen gehörten zum Alltag. Die zweite Welle, zu der auch SeeDance 2.0 zählt, verschiebt den Fokus. Es geht nicht mehr nur um „Kann die KI ein Video erzeugen?“, sondern um „Kann ich das Video präzise steuern?“.

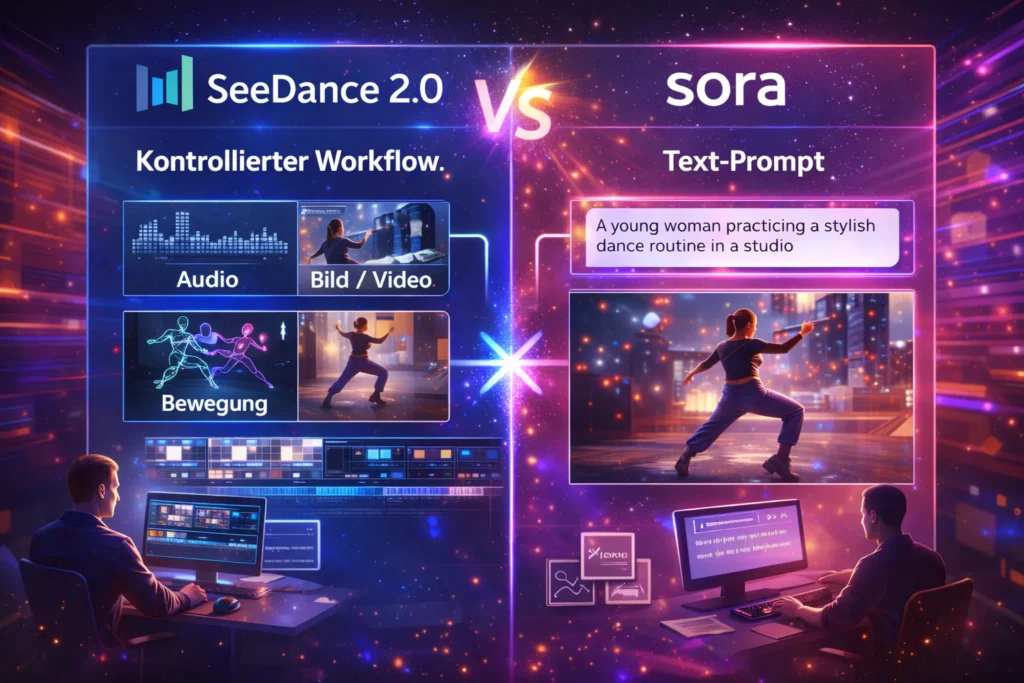

Genau hier setzt ByteDance an. SeeDance 2.0 wird nicht als reiner Generator positioniert, sondern als Produktionswerkzeug. Das Modell kombiniert Video-, Bild- und Audiogenerierung in einem System und verspricht eine neue Form der Kontrolle. Statt einem Prompt, der möglichst viel beschreibt, können mehrere Referenzen gleichzeitig genutzt werden. Bilder definieren Charaktere und Umgebungen, Videos liefern Bewegungsmuster, Audiodateien geben Rhythmus oder Stimmung vor. Das Ergebnis wirkt weniger zufällig und näher an professionellen Workflows.

Hinzu kommt der geopolitische Kontext. Während westliche Anbieter wie OpenAI mit Sora oder Google mit Veo zuletzt nur punktuell neue Fortschritte präsentierten, treiben chinesische Unternehmen die visuelle KI sichtbar aggressiv voran. Modelle wie Kling, WAN oder Hailuo haben bereits gezeigt, dass sich die Innovationsdynamik verschoben hat. SeeDance 2.0 fügt sich in diese Entwicklung ein – mit dem Unterschied, dass es die Diskussion nicht nur technisch, sondern auch rechtlich und ethisch auflädt.

Die Aufmerksamkeit entsteht also aus einer Kombination von Faktoren: technologischer Qualität, neuer Steuerbarkeit, strategischer Positionierung im globalen KI-Wettbewerb und einer Debatte um Urheberrecht und Trainingsdaten. SeeDance 2.0 trifft damit einen Moment, in dem sich viele fragen, wie nah wir wirklich an vollautomatisierter Filmproduktion sind – und welche Rolle Kreative künftig spielen werden.

2. Was SeeDance 2.0 technisch von anderen Video-KIs unterscheidet

Der zentrale Unterschied von SeeDance 2.0 liegt nicht in einem einzelnen Feature, sondern im zugrunde liegenden Architekturansatz. Während viele bisherige Video-KI-Modelle als Erweiterung klassischer Text-zu-Bild-Systeme gedacht waren, wurde SeeDance 2.0 von Beginn an als multimodales Produktionsmodell konzipiert. Text, Bild, Video und Audio sind keine nachgelagerten Module, sondern gleichwertige Eingabekanäle innerhalb eines Systems.

Das mag auf den ersten Blick nach einem Detail klingen, hat aber massive Auswirkungen auf das Ergebnis. Klassische Text-to-Video-Modelle versuchen, aus einer textuellen Beschreibung ein visuelles Ergebnis zu „erraten“. Je länger oder komplexer der Prompt wird, desto höher ist die Wahrscheinlichkeit, dass Details verloren gehen oder sich widersprechen. Genau dieses Problem ist einer der Hauptgründe für inkonsistente Szenen, wechselnde Charaktere oder unlogische Bewegungsabläufe.

SeeDance 2.0 geht einen anderen Weg. Anstatt alles aus Text zu extrapolieren, nutzt das Modell konkrete Referenzen, um Unsicherheiten zu reduzieren. Bilder definieren visuelle Identitäten, Videos liefern reale Bewegungsmuster, Audio gibt Timing und Stimmung vor. Der Text dient nicht mehr als alleiniger Bauplan, sondern als koordinierendes Element zwischen mehreren klar definierten Inputs.

Technisch bedeutet das: Das Modell muss nicht nur Inhalte generieren, sondern Beziehungen zwischen Modalitäten verstehen und synchronisieren. Ein Charakter bleibt konsistent, weil er an ein Referenzbild gebunden ist. Bewegungen wirken natürlicher, weil sie aus realen Videosequenzen abgeleitet werden. Audio passt besser, weil Bild- und Tonerzeugung nicht unabhängig voneinander stattfinden.

Ein weiterer Unterschied ist der Fokus auf zeitliche Kohärenz. Viele frühe Video-KIs konnten einzelne Frames oder kurze Sequenzen überzeugend darstellen, scheiterten aber daran, Objekte über mehrere Sekunden stabil zu halten. SeeDance 2.0 adressiert dieses Problem explizit. Laut ByteDance wurde viel Entwicklungsarbeit darauf verwendet, das „Vergessen“ von Details zu minimieren und physikalische Grundregeln zuverlässiger einzuhalten. Das Ergebnis sind Clips, die weniger flackern und sich stärker wie zusammenhängende Szenen anfühlen.

Im Vergleich dazu wirken andere aktuelle Modelle stärker fragmentiert. Systeme wie OpenAI Sora oder Google Veo haben eindrucksvoll gezeigt, was mit Text-to-Video möglich ist, setzen aber weiterhin stark auf probabilistische Generierung. Die kreative Kontrolle bleibt dort begrenzt und erfordert oft viele Iterationen, um ein brauchbares Ergebnis zu erzielen.

SeeDance 2.0 positioniert sich damit weniger als Experimentierwerkzeug und stärker als kontrollierbare Produktionsumgebung. Der technische Anspruch ist nicht, möglichst spektakuläre Einzelframes zu erzeugen, sondern reproduzierbare Ergebnisse zu liefern, die sich gezielt beeinflussen lassen. Genau dieser Paradigmenwechsel ist der Grund, warum viele SeeDance 2.0 nicht einfach als „bessere Video-KI“, sondern als neue Kategorie einordnen.

3. Director-Level Control: Von der Blackbox zur gezielten Regie

Der vielleicht größte Paradigmenwechsel von SeeDance 2.0 ist der Übergang von einer schwer kalkulierbaren Blackbox hin zu einem System, das gezielte Regieentscheidungen erlaubt. Wer bisher mit Video-KIs gearbeitet hat, kennt das Grundproblem: Ein Prompt beschreibt eine Szene, das Modell interpretiert ihn nach Wahrscheinlichkeiten. Kleine Änderungen im Text führen oft zu völlig anderen Ergebnissen. Kontrolle entsteht eher durch Ausprobieren als durch Planung.

SeeDance 2.0 dreht dieses Verhältnis um. Im Mittelpunkt steht nicht mehr die Hoffnung auf ein gutes Ergebnis, sondern die bewusste Steuerung einzelner Bestandteile. Möglich wird das durch ein Referenzsystem, bei dem hochgeladene Medien nicht nur als Inspiration dienen, sondern funktional eingebunden werden. Ein Bild ist nicht einfach „Stilvorlage“, sondern definiert konkret einen Charakter oder eine Umgebung. Ein Video ist nicht nur visuelle Anregung, sondern liefert reale Bewegungsdaten. Eine Audiodatei beeinflusst Rhythmus, Timing und Stimmung.

Damit nähert sich die Arbeit mit SeeDance 2.0 erstmals einem echten Regieprozess an. Statt abstrakt zu beschreiben, wie sich etwas bewegen soll, kann man zeigen, wie es sich bewegt. Statt zu erklären, wie eine Kamera fahren soll, kann man eine Referenz verwenden. Das reduziert Interpretationsspielraum und macht Ergebnisse reproduzierbarer. Kreative Entscheidungen werden explizit, nicht implizit.

Besonders relevant ist das für komplexe Szenen. Mehrere Charaktere, wechselnde Perspektiven oder dynamische Abläufe waren bislang eine der größten Schwächen generativer Video-KI. Durch die Kombination mehrerer Referenzen lassen sich nun Bewegungsabläufe, Kamerafahrten und visuelle Elemente getrennt definieren und anschließend zusammenführen. Das Modell agiert weniger wie ein autonomer Ideengeber und mehr wie ein ausführendes System.

Diese Form der Kontrolle verändert auch den kreativen Workflow. Statt endloser Prompt-Iteration entsteht ein strukturierter Prozess: Auswahl der Referenzen, Definition der Rollen, Feinschliff über Text. Das spart Zeit, reduziert Frustration und macht den Einsatz planbar. Genau dieser Aspekt ist entscheidend für den professionellen Einsatz, etwa im Marketing, in der Content-Produktion oder in Agentur-Setups.

An dieser Stelle zeigt sich auch, warum SeeDance 2.0 für Unternehmen interessanter ist als viele frühere Modelle. Es geht nicht darum, zufällig virale Clips zu erzeugen, sondern konsistente Inhalte, die sich an Marken, Kampagnen oder Storylines anpassen lassen. Kontrolle wird zur Voraussetzung für Skalierung. Wer sich bereits mit Automatisierung und KI-Workflows beschäftigt, erkennt hier schnell das Potenzial. Systeme, die sich zuverlässig steuern lassen, können in Prozesse eingebunden werden, statt isolierte Experimente zu bleiben. Genau dort beginnt der eigentliche strategische Mehrwert solcher Modelle.

4. Audio, Bewegung, Konsistenz: Warum SeeDance 2.0 professioneller wirkt

Ein entscheidender Grund, warum viele SeeDance-2.0-Clips auf den ersten Blick „fertiger“ wirken als Ergebnisse anderer Video-KIs, liegt im Zusammenspiel aus Bewegung, Audio und zeitlicher Stabilität. Genau an diesen Punkten sind frühere Modelle oft gescheitert. Einzelne Frames sahen gut aus, doch über mehrere Sekunden hinweg brach die Illusion zusammen. Figuren veränderten unbemerkt ihr Aussehen, Bewegungen wirkten ruckelig und Ton musste mühsam nachträglich ergänzt werden.

SeeDance 2.0 adressiert diese Schwächen systematisch. Besonders auffällig ist die Bewegungsübertragung. Statt Bewegungen rein zu synthetisieren, kann das Modell reale Abläufe aus Referenzvideos extrahieren und auf neue Charaktere übertragen. Gestik, Laufbewegungen oder einfache Kampfsequenzen behalten dadurch eine physikalische Logik, die bislang nur schwer zu erreichen war. Die Bewegungen fühlen sich weniger generiert und stärker „aufgenommen“ an.

Eng damit verknüpft ist die verbesserte Identitäts- und Szenenkonsistenz. Charaktere behalten Gesichtszüge, Proportionen und Kleidung deutlich stabiler über mehrere Sekunden hinweg. Auch Umgebungen verändern sich weniger abrupt. Dieses Verhalten ist kein Zufall, sondern Ergebnis eines klaren Entwicklungsziels: zeitliche Kohärenz. Für professionelle Nutzung ist das entscheidend, denn nur konsistente Clips lassen sich schneiden, kombinieren oder in Kampagnen integrieren.

Ein weiterer Schritt nach vorne ist die native Audio-Generierung. Während Ton bei vielen Video-KIs bislang ausgelagert war, erzeugt SeeDance 2.0 Audio direkt im Kontext des Bildes. Visuelle Ereignisse wie Schritte, Kollisionen oder Umgebungsgeräusche werden erkannt und akustisch begleitet. Auch Rhythmus und Stimmung lassen sich über Audiodateien beeinflussen, die das Modell in Bild und Bewegung übersetzt. Das reduziert nicht nur den Post-Production-Aufwand, sondern verhindert typische Synchronisationsprobleme.

Gerade im Marketing- und Content-Kontext ist das relevant. Kurze Videos für Social Media, Ads oder Landingpages müssen schnell produziert und angepasst werden. Wenn Bild, Bewegung und Ton bereits in einem Schritt stimmig entstehen, verkürzt sich der gesamte Produktionsprozess erheblich. SeeDance 2.0 wirkt deshalb weniger wie ein Experiment und mehr wie ein Werkzeug, das reale Arbeitsabläufe abbildet.

Natürlich ist auch dieses Modell nicht fehlerfrei. In dynamischen Szenen oder bei vielen gleichzeitig agierenden Figuren treten weiterhin typische KI-Artefakte auf. Doch die Richtung ist klar: Die Qualität entsteht nicht mehr allein durch bessere Bilder, sondern durch das Zusammenspiel aller Ebenen. Genau das ist der Unterschied zwischen einem beeindruckenden Demo-Clip und einem Video, das tatsächlich eingesetzt werden kann.

5. Vergleich mit Sora, Veo & Co.: Warum ByteDance aktuell vorne liegt

Um die Bedeutung von SeeDance 2.0 einzuordnen, lohnt sich ein Blick auf die aktuelle Landschaft der Video-KI. Spätestens seit der Vorstellung von Sora war klar, dass generative Modelle das Potenzial haben, Videoproduktion grundlegend zu verändern. Doch zwischen beeindruckenden Demos und produktiver Nutzbarkeit klaffte bislang eine Lücke. Genau diese Lücke versucht ByteDance zu schließen.

Modelle wie OpenAI Sora oder Google Veo setzen stark auf probabilistische Generierung. Ein gut formulierter Prompt kann außergewöhnliche Ergebnisse liefern, doch die Kontrolle bleibt begrenzt. Wer ein bestimmtes Ergebnis reproduzieren möchte, ist auf viele Iterationen angewiesen. Kleine Änderungen führen oft zu komplett neuen Szenen. Für kreative Experimente ist das spannend, für planbare Produktionsprozesse jedoch problematisch.

SeeDance 2.0 verfolgt einen anderen Ansatz. Statt primär auf immer größere Modelle und mehr Rechenleistung zu setzen, liegt der Fokus auf steuerbaren Inputs. Bilder, Videos und Audio dienen nicht als optionale Inspiration, sondern als feste Parameter. Das reduziert Zufall und erhöht Vorhersagbarkeit. Der Unterschied zeigt sich weniger in spektakulären Einzelbildern als im Gesamtverhalten des Systems.

Auch beim Thema Audio geht ByteDance weiter als viele westliche Wettbewerber. Während Ton dort häufig getrennt erzeugt oder nachträglich ergänzt wird, ist er bei SeeDance 2.0 integraler Bestandteil des Modells. Das Ergebnis wirkt geschlossener und näher an realen Produktionsstandards.

Ein weiterer Faktor ist die Entwicklungsgeschwindigkeit. In den letzten Monaten haben mehrere chinesische Anbieter ihre Video-KI-Modelle in kurzen Abständen verbessert. Iterationen erfolgen schneller, Funktionen werden pragmatischer eingeführt. Westliche Anbieter agieren dagegen vorsichtiger, nicht zuletzt aufgrund regulatorischer und rechtlicher Rahmenbedingungen. Diese Vorsicht ist nachvollziehbar, verlangsamt aber Innovation.

Gleichzeitig muss man die offiziellen Vergleiche relativieren. Viele Benchmarks stammen direkt von den Herstellern und sind nicht unabhängig überprüft. „Besser“ bedeutet hier nicht, dass andere Modelle unbrauchbar wären. Es bedeutet vielmehr, dass ByteDance aktuell einen klaren Fokus auf Workflow, Kontrolle und Integration legt – Aspekte, die für Unternehmen und Agenturen oft wichtiger sind als maximale visuelle Extravaganz.

In Summe liegt der Vorsprung von SeeDance 2.0 weniger in der reinen Bildqualität, sondern in der Ausrichtung. Das Modell ist nicht als technologische Machtdemonstration gedacht, sondern als Werkzeug, das sich in reale Prozesse einfügt. Genau deshalb wird es von vielen nicht als Konkurrenzprodukt zu Sora oder Veo wahrgenommen, sondern als nächste Evolutionsstufe der Video-KI.

6. Kreative Möglichkeiten – und wo die Grenzen (noch) liegen

Die Vielzahl an Beispielen, die in den letzten Tagen rund um SeeDance 2.0 aufgetaucht sind, zeigt vor allem eines: Das kreative Potenzial ist enorm. Atmosphärische Kurzfilme, dynamische Actionszenen, stilisierte Anime-Sequenzen oder professionell wirkende Promo-Clips lassen sich mit vergleichsweise wenig Aufwand umsetzen. Besonders stark ist das Modell dort, wo klare Referenzen vorliegen und Bewegungen, Kamera oder Stil bewusst geführt werden.

Für Kreative eröffnet das neue Spielräume. Bewegungsabläufe können gezielt übernommen, visuelle Stile konsistent gehalten und Szenen modular aufgebaut werden. Wer bisher mit Video-KI gearbeitet hat, kennt das Problem, dass gute Ergebnisse oft Zufallsprodukte waren. SeeDance 2.0 verschiebt diese Logik. Die Qualität entsteht weniger durch Glück, sondern durch Vorbereitung und Struktur.

Gleichzeitig wäre es falsch, das Modell als ausgereift oder allumfassend zu betrachten. Bestimmte Grenzen sind weiterhin deutlich sichtbar. In sehr komplexen Szenen mit vielen gleichzeitig interagierenden Figuren treten nach wie vor Inkonsistenzen auf. Kleidung verändert sich ungewollt, Objekte verschwinden kurzzeitig oder werden falsch interpretiert. Auch bei schnellen Kameraschwenks oder Verfolgungsjagden kippt die Optik gelegentlich in eine videogameartige Anmutung.

Ein weiterer limitierender Faktor ist die kreative Abhängigkeit von gutem Ausgangsmaterial. SeeDance 2.0 belohnt präzise Referenzen, setzt diese aber auch voraus. Wer keine passenden Bilder, Videos oder Audios liefern kann, erhält weniger kontrollierbare Ergebnisse. Das Modell ersetzt damit nicht die kreative Vorarbeit, sondern verschiebt sie. Die eigentliche Arbeit liegt nicht mehr im endlosen Prompten, sondern im Kuratieren und Strukturieren der Inputs.

Hinzu kommen aktuelle Einschränkungen bei der Verfügbarkeit. SeeDance 2.0 ist bislang nur über ausgewählte Plattformen zugänglich und noch nicht frei nutzbar. Für viele Unternehmen bleibt das Modell daher vorerst ein Blick in die nahe Zukunft, nicht sofort einsetzbare Alltagstechnologie.

All das zeigt: SeeDance 2.0 ist kein magischer Ersatz für Kreativität, Storytelling oder visuelle Kompetenz. Es ist ein Werkzeug, das gute Ideen schneller umsetzbar macht und schlechte Ideen nicht automatisch verbessert. Der Unterschied zu früheren Video-KIs liegt darin, dass die Grenzen klarer werden. Wer versteht, was das Modell kann und was nicht, kann es gezielt einsetzen. Wer es als Abkürzung für fehlende Konzeption betrachtet, wird enttäuscht werden.

7. Rechtliche und ethische Sprengkraft von SeeDance 2.0

Mit der wachsenden Leistungsfähigkeit von SeeDance 2.0 rückt ein Thema in den Vordergrund, das weit über technische Fragen hinausgeht: Recht, Ethik und Verantwortung. Die Diskussion entzündet sich weniger daran, dass das Modell beeindruckende Videos erzeugt, sondern womit es das offenbar gelernt hat und was damit möglich ist.

Ein zentraler Kritikpunkt ist die Fähigkeit, reale Personen und bekannte Figuren täuschend echt darzustellen. In Umlauf befindliche Clips zeigen Schauspieler, Prominente oder ikonische Charaktere in Szenen, die kaum noch von echten Filmaufnahmen zu unterscheiden sind. Gesichter, Körpersprache und sogar schauspielerische Nuancen wirken so präzise, dass die Grenze zwischen Fiktion und Realität verschwimmt. Genau hier beginnt die rechtliche Grauzone – und für viele Akteure ist sie längst überschritten.

Hollywood-Studios und Branchenverbände haben entsprechend schnell reagiert. Organisationen wie die Motion Picture Association werfen ByteDance vor, urheberrechtlich geschützte Werke in großem Umfang ohne Genehmigung für das Training des Modells genutzt zu haben. Besonders brisant ist dabei nicht nur die Nutzung einzelner Bilder oder Szenen, sondern die Möglichkeit, Stil, Charaktere und visuelle Sprache kompletter Franchises zu reproduzieren.

Auch Interessenvertretungen von Kreativen schlagen Alarm. Die Schauspieler- und Autorenvereinigung SAG-AFTRA sieht durch Modelle wie SeeDance 2.0 grundlegende Prinzipien der Zustimmung und Vergütung verletzt. Wenn digitale Abbilder von Schauspielern ohne deren Einwilligung generiert und verbreitet werden können, stellt das das bisherige Verständnis von Persönlichkeitsrechten infrage. Ähnliche Sorgen äußern Drehbuchautoren, Regisseure und Designer, deren Arbeit als Trainingsgrundlage dient, ohne dass sie daran beteiligt werden.

Für Unternehmen und Marken ist diese Debatte keineswegs ein abstraktes Hollywood-Problem. Wer Video-KI einsetzt, bewegt sich künftig in einem Spannungsfeld aus technischer Machbarkeit und rechtlicher Zulässigkeit. Inhalte, die heute technisch möglich sind, können morgen rechtlich angreifbar sein. Das betrifft nicht nur offensichtliche Deepfakes, sondern auch subtilere Formen der Anlehnung an bekannte Stile, Figuren oder Bildwelten.

ByteDance selbst hat auf den Druck reagiert und angekündigt, bestimmte Nutzungen einzuschränken. Prompts mit realen Personen, Filmtiteln oder geschützten Figuren sollen stärker blockiert werden. Ob diese Maßnahmen ausreichen, bleibt offen. Klar ist jedoch: Mit SeeDance 2.0 ist eine Schwelle überschritten, an der Regulierung, Transparenz und klare Spielregeln unausweichlich werden.

Die eigentliche Frage lautet daher nicht, ob solche Modelle kommen – sie sind bereits da. Die Frage ist, wie verantwortungsvoll sie eingesetzt werden und wer die Kontrolle darüber behält. Für Kreative, Agenturen und Unternehmen wird es entscheidend sein, technologische Möglichkeiten nicht isoliert zu betrachten, sondern immer auch ihre rechtlichen und ethischen Konsequenzen mitzudenken.

8. Was das für Marketing, Content-Produktion und Agenturen bedeutet

Für Marketingteams, Content-Creator und Agenturen markiert SeeDance 2.0 einen klaren Wendepunkt. Die entscheidende Veränderung ist nicht, dass Videos plötzlich „per Knopfdruck“ entstehen, sondern dass sich Produktionslogiken verschieben. Video wird planbarer, modularer und schneller iterierbar. Damit verändert sich auch die Frage, wo der eigentliche Wert in der Content-Produktion liegt.

Bislang war Videoproduktion stark durch Ressourcen begrenzt: Dreh, Technik, Postproduktion, Abstimmungsschleifen. SeeDance 2.0 reduziert viele dieser Hürden. Kurze Clips für Kampagnen, Landingpages oder Social Media lassen sich schneller erzeugen und variieren. Unterschiedliche Versionen für Zielgruppen, Formate oder Märkte werden nicht mehr zur Kostenfrage, sondern zur strategischen Entscheidung.

Gleichzeitig steigt der Anspruch an Konzeption und Steuerung. Wenn technische Umsetzung weniger limitiert ist, rückt die Qualität der Idee in den Vordergrund. Wer kein klares Ziel, keine Story oder keine visuelle Leitlinie hat, produziert auch mit Video-KI nur austauschbaren Content. Der Wettbewerbsvorteil liegt nicht im Tool selbst, sondern im Verständnis dafür, wie man es sinnvoll einsetzt.

Besonders spannend wird SeeDance 2.0 im Zusammenspiel mit Automatisierung. Video-KI entfaltet ihren größten Nutzen, wenn sie Teil eines größeren Workflows ist: von der Ideenfindung über die Erstellung bis hin zur Ausspielung. In Kombination mit Automatisierungsplattformen wie n8n lassen sich perspektivisch Prozesse aufbauen, bei denen Videos datengetrieben generiert, angepasst und verteilt werden. Wer sich tiefer mit solchen Workflows beschäftigen möchte, sollte unbedingt unseren Blogbeitrag zum Thema „n8n“ durchlesen

Für Agenturen bedeutet das eine Neuausrichtung ihrer Rolle. Reine Umsetzung verliert an Bedeutung, strategische Beratung gewinnt. Kunden brauchen Orientierung: Welche Inhalte lassen sich sinnvoll automatisieren? Wo ist individuelle Produktion weiterhin notwendig? Wie vermeidet man rechtliche Risiken? SeeDance 2.0 verstärkt diesen Bedarf, statt ihn zu reduzieren.

Am Ende profitieren vor allem diejenigen, die Technologie nicht isoliert betrachten. Video-KI ist kein Ersatz für Marketingstrategie, sondern ein Beschleuniger. Sie erlaubt es, Ideen schneller sichtbar zu machen, Hypothesen zu testen und Content iterativ zu verbessern. Wer diese Möglichkeiten strukturiert nutzt, kann Reichweite und Effizienz steigern, ohne Qualität zu opfern.

9. Einordnung aus Agenturperspektive: Chancen realistisch nutzen

Aus Agentur- und Unternehmenssicht ist SeeDance 2.0 vor allem eines: ein Katalysator. Nicht jede neue Technologie verändert sofort alles, aber sie verschiebt Erwartungen. Kunden werden sich daran gewöhnen, dass Video schneller produziert, häufiger angepasst und stärker personalisiert werden kann. Gleichzeitig steigt der Anspruch an Klarheit, Konsistenz und strategische Einbettung.

Genau hier entscheidet sich, wer von Video-KI profitiert und wer nicht. Der Einsatz von SeeDance 2.0 ersetzt keine Markenstrategie, keine Zielgruppenanalyse und kein sauberes Messaging. Im Gegenteil: Je leistungsfähiger die Werkzeuge werden, desto sichtbarer werden konzeptionelle Schwächen. Ein Tool, das sich präzise steuern lässt, macht unklare Vorgaben sofort deutlich.

Für Agenturen bedeutet das, den Fokus zu verschieben. Statt primär Videos zu „produzieren“, geht es darum, Produktionssysteme zu entwerfen. Welche Inhalte brauchen Kunden regelmäßig? Welche Variationen sind sinnvoll? Wo lassen sich Templates, Referenzen und Regeln definieren, die konsistente Ergebnisse liefern? Video-KI entfaltet ihren Wert nicht im Einzelfall, sondern in wiederholbaren Prozessen.

Gleichzeitig ist Zurückhaltung gefragt. Nicht jeder Use Case eignet sich für automatisierte Videogenerierung. Hochsensible Markenkommunikation, komplexes Storytelling oder Inhalte mit rechtlichem Risiko verlangen weiterhin menschliche Kontrolle. SeeDance 2.0 ist ein starkes Werkzeug, aber kein Autopilot. Wer es unreflektiert einsetzt, riskiert Inkonsistenzen oder rechtliche Probleme.

Aus unserer Sicht liegt die eigentliche Chance deshalb nicht im „schneller, billiger, mehr“, sondern im besseren Einsatz von Ressourcen. Video-KI kann Freiräume schaffen: für Ideen, für Tests, für strategische Arbeit. Sie ermöglicht es, Konzepte zu validieren, bevor große Budgets fließen, und Inhalte datenbasiert weiterzuentwickeln.

Wenn du dich gerade mit der Frage beschäftigst, wie solche Technologien sinnvoll in Marketing- oder Content-Strategien integriert werden können, lohnt sich ein strukturierter Blick von außen. Oft geht es weniger um das Tool selbst als um den passenden Rahmen dafür. Ein unverbindliches Gespräch kann helfen, Chancen realistisch einzuordnen und Risiken früh zu erkennen.

10. Fazit: Warum SeeDance 2.0 mehr als nur ein weiteres KI-Tool ist

SeeDance 2.0 markiert keinen einzelnen Technologiesprung, sondern einen Richtungswechsel. Video-KI entwickelt sich weg vom reinen Experimentierfeld hin zu einem steuerbaren Produktionswerkzeug. Der entscheidende Fortschritt liegt nicht allein in höherer Bildqualität, sondern in der Kombination aus Kontrolle, Konsistenz und integriertem Workflow. Genau diese Eigenschaften machen das Modell für professionelle Anwendungsfälle relevant.

ByteDance zeigt mit SeeDance 2.0, dass sich Videogenerierung nicht länger auf das Erraten eines guten Ergebnisses beschränken muss. Referenzen, Bewegungsübertragung und native Audiointegration verschieben die Arbeit hin zur bewussten Regie. Das verändert, wie Kreative, Marketingteams und Agenturen denken müssen: Vorbereitung und Struktur gewinnen an Bedeutung, Zufall verliert an Stellenwert.

Gleichzeitig macht das Modell sichtbar, wo neue Konfliktlinien verlaufen. Rechtliche Fragen, Persönlichkeitsrechte und der Umgang mit Trainingsdaten sind keine Randthemen mehr. Wer Video-KI einsetzt, trägt Verantwortung – technisch wie strategisch. SeeDance 2.0 zwingt die Branche, sich nicht nur mit Möglichkeiten, sondern auch mit Grenzen auseinanderzusetzen.

Am Ende entscheidet nicht das Tool, sondern der Umgang damit. SeeDance 2.0 wird keine guten Ideen ersetzen, aber es kann sie schneller sichtbar machen. Es wird keine Strategie liefern, aber es kann ihre Umsetzung beschleunigen. Genau darin liegt seine eigentliche Bedeutung: als Katalysator für neue Workflows, neue Erwartungen und eine neue Phase der Videoproduktion.